Искусственный интеллект и Джеффри Хинтон: отец «глубокого обучения»

Искусственный интеллект. Сколько о нем сказано, а ведь мы даже и говорить еще толком не начинали. Почти все, что вы слышите о прогрессе искусственного интеллекта, основано на прорыве, которому тридцать лет. Сохранение темпов прогресса потребует обхода серьезных ограничений серьезных ограничений. Далее от первого лица — Джеймс Сомерс.

Я стою там, где скоро будет центр мира, или просто в большой комнате на седьмом этаже блестящей башни в центре Торонто — с какой стороны посмотреть. Меня сопровождает Джордан Джейкобс, сооснователь этого места: Института Вектор, который осенью этого года открывает свои двери и обещает стать глобальным эпицентром искусственного интеллекта.

Мы в Торонто, потому что Джеффри Хинтон в Торонто. А Джеффри Хинтон — отец «глубокого обучения», техники, лежащей в основе ажиотажа на тему ИИ. «Через 30 лет мы оглянемся назад и скажем, что Джефф — Эйнштейн для ИИ, глубокого обучения, всего, что мы зовем искусственным интеллектом», говорит Джейкобс. Из всех исследователей ИИ Хинтона цитируют чаще, чем трех идущих за ним, вместе взятых. Его студенты и аспиранты уходят работать в лаборатории ИИ в Apple, Facebook и OpenAI; сам Хинтон — ведущий ученый в команде Google Brain AI. Практически любое достижение в области ИИ за последние десять лет — в переводе, распознавании речи, распознавании изображений и играх — так или иначе касается работы Хинтона.

Институт Вектор, этот памятник восхождению идей Хинтона, является исследовательским центром, в котором компании со всех США и Канады — вроде Google, Uber и NVIDIA — спонсируют усилия по коммерциализации технологий ИИ. Деньги вливаются быстрее, чем Джейкобс успевает об этом попросить; двое из его соучредителей опрашивали компании в области Торонто, и спрос на экспертов в области ИИ оказался в 10 раз выше, чем поставляет Канада каждый год. Институт Вектор в некотором смысле непаханая целина для попытки мобилизовать мир вокруг глубокого обучения: чтобы вложиться в эту технику, научить ей, отточить и применять. Дата-центры строятся, небоскребы наполняются стартапами, в область вливаются целые поколения студентов.

Когда стоишь на полу «Вектора», складывается ощущение, что вы в начале чего-то. Но глубокое обучение, по своей сути, очень старо. Прорывная статья Хинтона, написанная вместе с Дэвидом Румельхартом и Рональдом Уильямсом, была опубликована в 1986 году. В работе подробно описывался метод обратного распространения ошибки (backpropagation), «бэкпроп», если коротко. Бэкпроп, по словам Джона Коэна, — это «все, на чем основано глубокое обучение — вообще все».

Если смотреть в корень, сегодня ИИ — это глубокое обучение, а глубокое обучение — это бэкпроп. И это поразительно, учитывая, что бэкпропу более 30 лет. Разобраться в том, как так получилось, просто необходимо: как техника могла ждать так долго и затем стать причиной взрыва? Потому что как только вы узнаете историю бэкпропа, вы поймете, что сейчас происходит с ИИ, а также и то, что мы можем и не стоять в начале революции. Возможно, мы в конце таковой.

Прогулка от Института Вектора в офис Хинтона в Google, где он проводит большую часть своего времени (он теперь почетный профессор Университета Торонто) — это своего рода живая реклама для города, по крайней мере летом. Становится понятно, почему Хинтон, который родом из Великобритании, переехал сюда в 1980-х после работы в Университете Карнеги — Меллона в Питтсбурге.

Может быть, мы не в самом начале революции

Торонто — четвертый по величине город Северной Америки (после Мехико, Нью-Йорка и Лос-Анджелеса) и уж точно разнообразней: больше половины населения было рождено за пределами Канады. И это видно, когда ходишь по городу. Толпа многонациональная. Есть бесплатное здравоохранение и хорошие школы, люди дружелюбны, политики относительно левые и стабильные; все это привлекает людей вроде Хинтона, который говорит, что уехал из США из-за «Ирангейта» (Иран-контрас — крупный политический скандал в США второй половины 1980-х годов; тогда стало известно о том, что отдельные члены администрации США организовали тайные поставки вооружения в Иран, нарушая тем самым оружейное эмбарго против этой страны). С этого начинается наш разговор перед обедом.

«Многие считали, что США вполне могут вторгнуться в Никарагуа», говорит он. «Они почему-то считали, что Никарагуа принадлежит США». Он рассказывает, что недавно осуществил большой прорыв в проекте: «Со мной начал работать очень хороший младший инженер», женщина по имени Сара Сабур. Сабур иранка, и ей было отказано в визе для работы в США. Офис Google в Торонто вытащил ее.

Хинтону 69 лет. У него острое, худощавое английское лицо с тонким ртом, большими ушами и гордым носом. Он родился в Уимблдоне и в разговоре напоминает рассказчика детской книжки про науку: любопытный, завлекающий, пытающийся все объяснить. Он забавный и немного играет на публику. Ему больно сидеть из-за проблем со спиной, поэтому летать он не может, а на приеме у дантиста ложится на приспособление, напоминающее доску для серфинга.

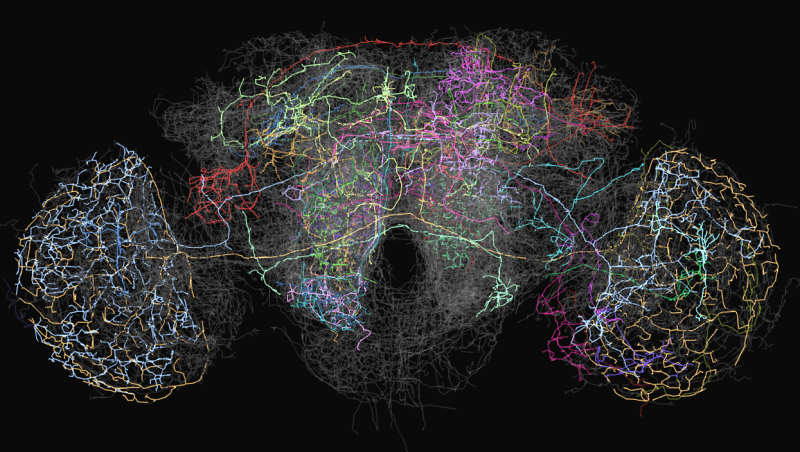

В 1980-х Хинтон был, как и сейчас, экспертом по нейронным сетям, значительно упрощенной модели сети нейронов и синапсов нашего мозга. Однако в то время было твердо решено, что нейронные сети — тупик в исследованиях ИИ. Хотя самая первая нейронная сеть «Перцептрон» была разработана в 1960-х годах и ее считали первым шагом в направлении машинного интеллекта человеческого уровня, в 1969 году Марвин Мински и Сеймур Паперт математически доказали, что такие сети могут выполнять лишь простейшие функции. У этих сетей было всего два слоя нейронов: слой ввода и слой вывода. Сети с большим числом слоев между нейронами ввода и вывода могли, в теории, решать широкое разнообразие проблем, но никто не знал, как их обучать, так что на практике они были бесполезными. Из-за «Перцептронов» от идеи нейронных сетей отказались почти все за несколькими исключениями, включая Хинтона.

Прорыв Хинтона в 1986 году состоял в том, чтобы показать, что метод обратного распространения ошибки может обучать глубокую нейронную сеть с количеством слоев больше двух или трех. Но потребовалось еще 26 лет, прежде чем увеличилась вычислительная мощь. В статье 2012 года Хинтон и два его студента из Торонто показали, что глубокие нейронные сети, обученные с применением бэкпропа, обошли самые лучшие системы распознавания изображений. «Глубокое обучение» начало набирать обороты. Мир в одночасье решил, что с утра ИИ захватит власть. Для Хинтона это была долгожданная победа.

Поле искажения реальности

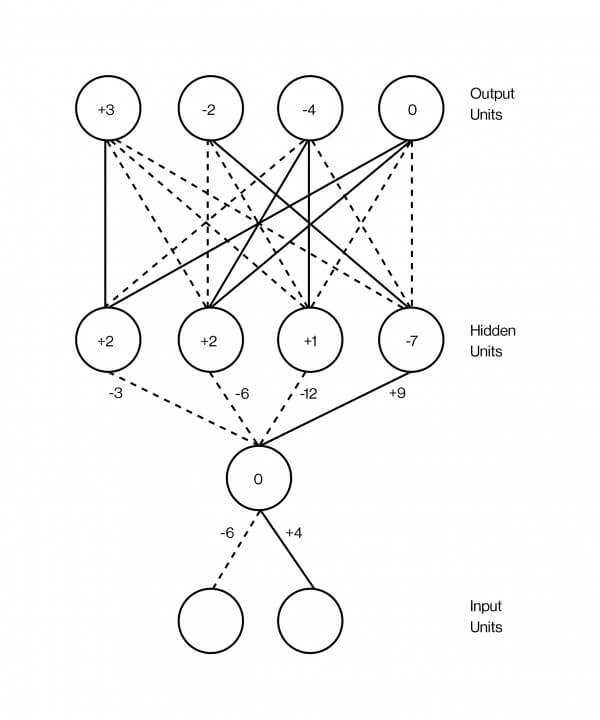

Нейронная сеть обычно изображается как сэндвич, слои которого наложены друг на друга. Эти слои содержат искусственные нейроны, которые по своей сути представлены маленькими вычислительными единицами, которые возбуждаются — как возбуждается настоящий нейрон — и передают это волнение другим нейронам, с которыми соединены. Возбуждение нейрона представлено числом, скажем, 0.13 или 32.39, которое определяет степень возбуждения нейрона. И есть другое важное число, на каждом из соединений между двумя нейронами, определяющее, сколько возбуждения должно передаваться от одного к другому. Это число моделирует силу синапсов между нейронами мозга. Чем выше число, тем сильнее связь, а значит больше возбуждения перетекает от одного к другому.

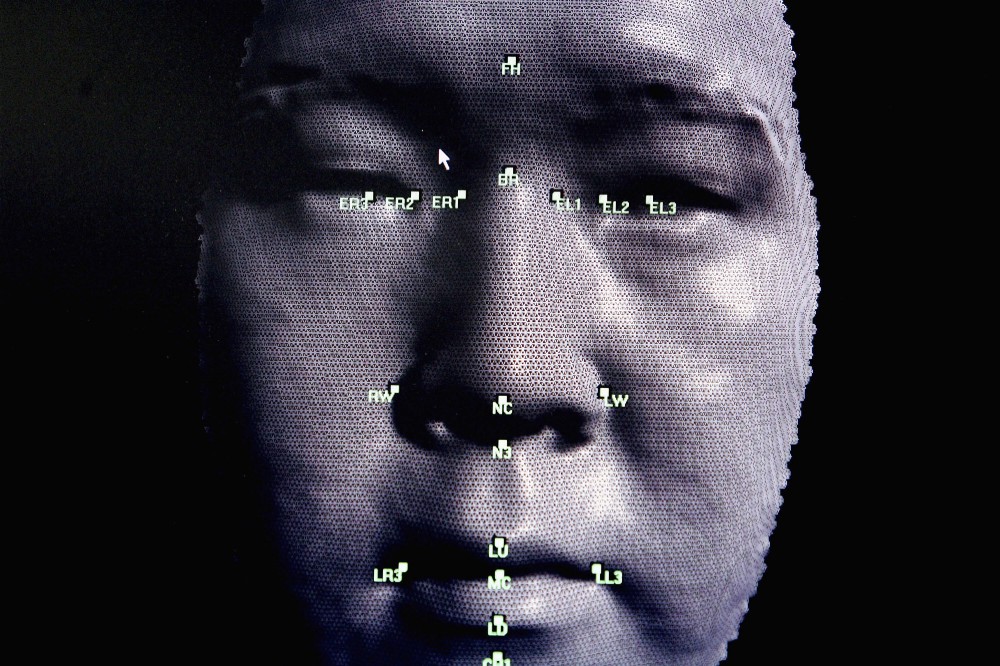

Одним из самых успешных применений глубоких нейронных сетей стало распознавание изображений. Сегодня существуют программы, способные распознать, есть ли на картинке хот-дог. Каких-то десять лет назад они были невозможны. Чтобы заставить их работать, сперва нужно взять картинку. Для простоты скажем, что это черно-белое изображение 100 на 100 пикселей. Вы скармливаете его нейронной сети, устанавливая возбуждение каждого моделируемого нейрона в вводном слое так, что оно будет равно яркости каждого пикселя. Это нижний слой сэндвича: 10 000 нейронов (100 х 100), представляющие яркость каждого пикселя на изображении.

Затем этот большой слой нейронов вы подключаете к другому большому слою нейронов, уже выше, скажем, в несколько тысяч, а их, в свою очередь, к другому слою из нескольких тысяч нейронов, но уже меньше и так далее. Наконец, верхний слой сэндвича — слой вывода — будет состоять из двух нейронов — одного, представляющего «хот-дог», а другого — «не хот-дог». Идея в том, чтобы обучить нейронную сеть возбуждать только первый из этих нейронов, если на картинке есть хот-дог, и второй, если нет. Бэкпроп, метод обратного распространения ошибки, на котором Хинтон построил свою карьеру, делает именно это.

Бэкпроп крайне прост, хотя лучше всего работает с огромным количеством данных. Вот почему большие данные так важны для ИИ — почему ими с таким рвением занимаются Facebook и Google и почему Vector Institute решил наладить связь с четырьмя крупнейшими больницами Канады и обмениваться данными.

В данном случае данные принимают форму миллионов изображений, некоторых с хот-догами, некоторых без; трюк в том, чтобы пометить эти изображения как имеющие хот-доги. Когда вы создаете нейронную сеть впервые, соединения между нейронами имеют случайные веса – случайные числа, которые говорят, сколько возбуждения передается через каждое соединение. Будто синапсы мозга еще не настроены. Цель бэкпропа — изменить эти веса так, чтобы сеть заработала: так что, когда вы передаете изображение хот-дога на самый нижний слой, нейрон «хот-дога» в самом верхнем слое возбуждается.

Предположим, вы берете первую обучающую картинку с изображением пианино. Вы преобразуете интенсивность пикселей изображения 100 х 100 в 10 000 чисел, по одному на каждый нейрон нижнего слоя сети. По мере того, как возбуждение распространяется по сети в соответствии с силой соединения нейронов в прилегающих слоях, все постепенно доходит до последнего слоя, одного из двух нейронов, которые определяют, есть на картинке хот-дог. Поскольку это картинка с пианино, нейрон «хот-дога» должен показать ноль, а нейрон «не хот-дога» должен показать число повыше. Допустим, все работает не так. Допустим, сеть ошиблась насчет изображения. Бэкпроп — это процедура укрепления силы каждого соединения в сети, позволяющая исправить ошибку в приведенном примере обучения.

Как это работает? Вы начинаете с последних двух нейронов и выясняете, насколько они ошибаются: какова разница между их числами возбуждения и какой она должна быть на самом деле. Затем вы просматриваете каждое соединение, ведущее к этим нейронам — спускаясь ниже по слоям — и определяете их вклад в ошибку. Вы продолжаете делать это, пока не дойдете до первого набора соединений на самом дне сети. К этому моменту вы знаете, каков вклад отдельного соединения в общую ошибку. Наконец, вы меняете все веса, чтобы в целом снизить шансы на ошибку. Этот так называемый «метод обратного распространения ошибки» заключается в том, что вы как бы прогоняете ошибки назад по сети, начиная с обратного конца, с выхода.

Невероятное начинает происходить, когда вы делаете это с миллионами или миллиардами изображений: сеть начинает хорошо определять, изображен на картинке хот-дог или нет. И что еще более примечательно, так это то, что отдельные слои этих сетей распознавания изображений начинают «видеть» изображения так же, как это делает наша собственная визуальная система. То есть первый слой обнаруживает контуры — нейроны возбуждаются, когда контуры есть, и не возбуждаются, когда их нет; следующий слой определяет наборы контуров, например, углы; следующий слой начинает различать формы; следующий слой находит всякие элементы вроде «открытой булочки» или «закрытой булочки», потому что активируются соответствующие нейроны. Сеть организуется в иерархические слои, даже не будучи запрограммированной таким образом.

Настоящий интеллект не смущается, когда проблема немного меняется.

Именно это так всех поразило. Дело не столько в том, что нейронные сети хорошо классифицируют изображения с хот-догами: они выстраивают репрезентации идей. С текстом это становится еще более очевидно. Можно скормить текст Википедии, много миллиардов слов, простой нейронной сети, научив ее наделять каждое слово числами, соответствующими возбуждениям каждого нейрона в слое. Если представить все эти числа координатами в сложном пространстве, вы находите точку, известную в данном контексте как вектор, для каждого слова в этом пространстве. Затем вы обучаете сеть так, что слова, появляющиеся рядом на страницах Википедии, будут наделяться похожими координатами — и вуаля, происходит нечто странное: слова, имеющие похожие значения, будут показываться рядом в этом пространстве. «Безумный» и «расстроенный» будут рядом; «три» и «семь» тоже. Более того, векторная арифметика позволяет вычесть вектор «Франции» из «Парижа», добавить его к «Италии» и найти «Рим» поблизости. Никто не говорил нейросети, что Рим для Италии — это то же, что Париж для Франции.

«Это удивительно», говорит Хинтон. «Это шокирует». Нейронные сети можно рассматривать как попытку взять вещи — изображения, слова, записи разговоров, медицинские данные — и поместить их в, как говорят математики, многомерное векторное пространство, в котором близость или удаленность вещей будет отражать важнейшие аспекты настоящего мира. Хинтон считает, что именно это делает мозг. «Если вы хотите узнать, что такое мысль, — говорит он, — я могу передать ее вам серией слов. Я могу сказать: «Джон подумал: «упс». Но если вы спросите: что такое мысль? Что значит для Джона иметь эту мысль? Ведь в его голове нет открывающихся кавычек, «упс», закрывающихся кавычек, вообще такого и близко нет. В его голове протекает некая нейронная активность». Большие картины нейронной активности, если вы математик, можно уловить в векторном пространстве, где активность каждого нейрона будет соответствовать числу, а каждое число — координате очень большого вектора. По мнению Хинтона, мысль — это танец векторов.

Теперь понятно, почему Институт Вектор назвали так?

Хинтон создает некое поле искажения реальности, вам передается чувство уверенности и энтузиазма, вселяющие веру в то, что для векторов нет ничего невозможного. В конце концов, они уже создали самоуправляемые автомобили, выявляющие рак компьютеры, мгновенные переводчики разговорного языка.

И только когда вы покидаете комнату, вы вспоминаете, что эти системы «глубокого обучения» все еще довольно глупы, несмотря на свою демонстративную силу мысли. Компьютер, который видит кучу пончиков на столе и автоматически подписывает ее как «кучу пончиков, лежащих на столе», кажется понимающим мир; но когда та же программа видит девушку, которая чистит зубы, и говорит, что это «мальчик с бейсбольной битой», вы осознаете, насколько неуловимое это понимание, если оно вообще есть.

Нейронные сети — это просто бездумные и расплывчатые распознаватели образов, и насколько полезными могут быть такие распознаватели образов — ведь их стремятся интегрировать в любое программное обеспечение — они в лучшем случае представляют ограниченную породу интеллекта, которую легко обмануть. Глубокая нейронная сеть, которая распознает изображения, может быть полностью сконфужена, если вы измените один пиксель или добавите визуальный шум, незаметный для человека. Почти так же часто, как мы находим новые способы применения глубокого обучения, так же часто мы сталкиваемся с его ограниченностью. Самоуправляемые автомобили не могут ехать в условиях, которых не видели прежде. Машины не могут разбирать предложения, которые требуют здравого смысла и понимания того, как устроен мир.

Глубокое обучение в некотором смысле имитирует происходящее в человеческом мозге, но поверхностно — что, возможно, объясняет, почему его интеллект оказывается таким поверхностным иногда. Бэкпроп не был обнаружен в процессе погружения в мозг, попытки расшифровать саму мысль; он вырос из моделей обучения животных методом проб и ошибок в старомодных экспериментах. И большинство важных шагов, которые были сделаны с момента его появления, не включали ничего нового на тему нейробиологии; это были технические улучшения, заслуженные годами работы математиков и инженеров. То, что мы знаем об интеллекте, ничто по сравнению с тем, чего мы о нем пока не знаем.

Дэвид Дювенод, ассистент профессора из того же отделения, что и Хинтон, в Университете Торонто, говорит, что глубокое обучение похоже на инженерию до введения физики. «Кто-то пишет работу и говорит: «Я сделал этот мост, и он стоит!». Другой пишет: «Я сделал этот мост, и он рухнул, но я добавил опоры и он стоит». И все сходят с ума по опорам. Кто-то добавляет арку — и все такие: арки это круто! С физикой же вы можете на самом деле понять, что будет работать и почему. Мы только недавно начали переходить к хоть какому-нибудь пониманию искусственного интеллекта».

И сам Хинтон говорит: «На большинстве конференций говорят о введении небольших изменений вместо того, чтобы хорошенько подумать и задаться вопросами: «Почему то, что мы делаем сейчас, не получается? С чем это связано? Давайте сосредоточимся на этом».

Взгляд со стороны трудно составить, когда все, что вы видите — это продвижение за продвижением. Но новейший прогресс в области ИИ в меньшей степени был научным и в большей — инженерным. Хотя мы стали лучше понимать, какие изменения улучшат системы глубокого обучения, мы пока смутно представляем, как эти системы работают и смогут ли они когда-нибудь собраться в нечто столь же мощное, как человеческий разум.

Важно понять, смогли ли мы извлечь все, что можно, из бэкпропа. Если да, то нас ждет плато в развитии искусственного интеллекта.

Терпение

Если вы хотите увидеть следующий прорыв, нечто вроде основы для машин с гораздо более гибким интеллектом, вы должны, по идее, обратиться к исследованиям, похожим на исследования бэкпропа в 80-е годы: когда умные люди сдавались, потому что их идеи пока не работали.

Несколько месяцев назад я побывал в Center for Minds, Brains and Machines, многоцелевом учреждении, расквартированном в MIT, чтобы посмотреть, как мой друг Эял Дехтер защищает свою диссертацию по когнитивной науке. Перед началом выступления его жена Эми, его пес Руби и его дочь Сюзанна поддержали его и пожелали удачи.

Эял начал свое выступление с увлекательного вопроса: как так получилось, что Сюзанна, которой всего два года, научилась говорить, играть, следить за рассказами? Что в мозге человеческом такого, что позволяет ему так хорошо учиться? Научится ли компьютер когда-нибудь учиться так быстро и плавно?

Мы понимаем новые явления с точки зрения вещей, которые мы уже понимаем. Мы разбиваем домен на куски и изучаем его по частям. Эял — математик и программист, он думает о задачах — например, сделать суфле — как о сложных компьютерных программах. Но ведь вы не учитесь делать суфле, заучивая сотни мельчайших инструкций программы вроде «поверните локоть на 30 градусов, затем посмотрите на столешницу, затем вытяните палец, затем…». Если бы нужно было делать это в каждом новом случае, обучение стало бы невыносимым, и вы бы остановились в развитии. Вместо этого мы видим в программе шаги высшего уровня вроде «взбейте белки», которые сами по себе состоят из субпрограмм вроде «разбейте яйца» и «отделите белки от желтков».

Компьютеры этого не делают и поэтому кажутся глупыми. Чтобы система глубокого обучения распознала хот-дог, вам придется скормить ей 40 миллионов изображений хот-догов. Чтоюы Сюзанна узнала хот-дог, просто покажите ей хот-дог. И задолго до этого у нее появится понимание языка, которое уходит сильно глубже распознания появления отдельных слов вместе. В отличие от компьютера, в ее голове есть представление о том, как работает мир. «Меня удивляет, что люди боятся, что компьютеры отнимут у них работу», говорит Эял. «Компьютеры смогут заменить юристов не потому, что юристы делают что-то сложное. А потому что юристы слушают и говорят с людьми. В этом смысле мы очень далеки от всего этого».

Настоящий интеллект не смутится, если вы слегка измените требования к решению проблемы. И ключевым тезисом Эяла была демонстрация именно этого, в принципе, как заставить компьютер работать таким образом: живо применять все, что он уже знает, к решению новых задач, быстро схватывать на лету, становиться экспертом в совершенно новой области.

По сути, это процедура, которую он называет алгоритмом «исследования-сжатия». Она дает компьютеру функцию программиста, собирающего библиотеку многоразовых модульных компонентов, позволяющую создавать более сложные программы. Ничего не зная о новом домене, компьютер пытается структурировать знание о нем, просто изучая его, консолидируя обнаруженное и далее изучая, подобно ребенку.

Его советник, Джошуа Тененбаум, — один из самых цитируемых исследователей ИИ. Имя Тененбаума всплывало в половине разговоров, которые я имел с другими учеными. Некоторые из ключевых людей в DeepMind — команды разработчиков AlphaGo, легендарно обыгравшего чемпиона мира по игре в го в 2016 году — работали под его началом. Он вовлечен в стартап, который пытается дать самоуправляемым автомобилям интуитивное понимание основ физики и намерений других водителей, чтобы те лучше предвосхищали происходящее в ситуациях, с которыми не сталкивались ранее.

Тезис Эяла пока не применялся на практике, даже в программы не вводился. «Проблемы, над которыми работает Эял, очень и очень сложные», говорит Тененбаум. «Нужно чтобы прошло много поколений».

Когда мы присели выпить по чашке кофе, Тененбаум сказал, что исследует историю бэкпропа ради вдохновения. На протяжении десятилетий бэкпроп был проявлением крутой математики, по большей части ни на что не способной. По мере того, как компьютеры становились быстрее, а техника сложнее, все менялось. Он надеется, что нечто подобное произойдет с его собственной работой и работами его учеников, но «это может занять еще пару десятилетий».

Что касается Хинтона, он убежден, что преодоление ограничений ИИ связано с созданием «моста между информатикой и биологией». Бэкпроп, с этой точки зрения, был триумфом биологически вдохновленных вычислений; идея изначально исходила не из инженерии, а из психологии. Поэтому теперь Хинтон пытается повторить этот трюк.

Сегодня нейронные сети состоят из больших плоских слоев, но в неокортексе человека настоящие нейроны выстраиваются не только горизонтально, но и вертикально, в столбцы. Хинтон догадывается, для чего нужны эти столбцы — в зрении, например, они позволяют распознавать объекты даже при изменении точки зрения. Поэтому он создает искусственную версию — и называет их «капсулами» — для проверки этой теории. Пока что ничего не выходит: капсулы не особо улучшили производительность его сетей. Но ведь 30 лет назад с бэкпропом было то же самое.

«Это должно сработать», говорит он о теории капсул, смеясь над собственной бравадой. «А то, что пока не работает, это лишь временное раздражение».

По материалам Medium.com